Copilot oder ChatGPT-Schulung? Warum kluge Assistenzkräfte beides brauchen – und Führungskräfte davon profitieren

Ein Blick in die Chefetage

Montagmorgen, 8:07 Uhr. Der Kalender ist dicht getaktet, die erste Mail eskaliert schon vor dem zweiten Kaffee, und irgendwo zwischen Jour fixe und Budgetrunde blinkt ein neues Versprechen auf: Microsoft Copilot.

„Endlich Entlastung“, denkt die Geschäftsführung. Zusammenfassungen auf Knopfdruck. Mails automatisch formuliert. Meetings, die sich fast von selbst organisieren.

Während oben die Effizienz gefeiert wird, sitzt unten im Sekretariat Frau Huber. Sie hat Copilot ebenfalls getestet. Sie sieht, was funktioniert – und was nicht.

Denn sie arbeitet nicht nur in Terminen, sie arbeitet zwischen ihnen. Sie vermittelt, strukturiert, fängt Brüche ab, denkt voraus. Genau dort beginnt die Realität, die kein Tool automatisch löst.

Frau Huber merkt schnell: Copilot hilft. Aber Copilot fragt nicht nach. Er erkennt keine unausgesprochenen Erwartungen, keine politischen Feinheiten, keine Übergaben zwischen Abteilungen.

Und genau deshalb bleibt bei ihr ein Rest Skepsis – nicht gegenüber der Technik, sondern gegenüber der Annahme, Technik allein reiche aus.

Was passiert, wenn Effizienz gefeiert wird, bevor Kompetenz aufgebaut ist?

Im Alltag der Assistenz bedeutet KI nicht nur Zeitersparnis. Sie bedeutet Verantwortung.

Wer entscheidet, welche Mail automatisch formuliert wird? Wer prüft Ton, Kontext, rechtliche Feinheiten? Wer greift ein, wenn Vorschläge „formal korrekt“, aber menschlich unpassend sind?

Frau Huber weiß: Wenn KI kommt, wird ihr Job nicht kleiner – sondern anspruchsvoller.

Und genau hier beginnt der eigentliche Grund, warum Copilot allein nicht reicht.

Warum eine ChatGPT-Schulung mehr ist als ein weiteres Tool

Die zentrale Frage, die sich viele Organisationen stellen, lautet nicht offen, aber deutlich:

Warum noch eine ChatGPT-Schulung, wenn Copilot doch schon da ist?

Diese Frage ist verständlich. Sie folgt einer klassischen Management-Logik: Tool vorhanden, Problem gelöst.

Doch Assistenzrealität funktioniert anders. Hier geht es nicht nur um Bedienung, sondern um Gestaltung.

Eine ChatGPT-Schulung zielt nicht darauf ab, ein weiteres Programm zu erklären. Sie zielt darauf ab, KI-Arbeitskompetenz aufzubauen.

Also die Fähigkeit, Aufgaben zu strukturieren, Prozesse zu denken, Wissen zu bündeln und Verantwortung bewusst zu übernehmen – mit oder ohne Microsoft-Ökosystem.

Frau Huber erlebt das täglich. Sie nutzt ChatGPT nicht, weil sie Outlook nicht beherrscht.

Sie nutzt es, um komplexe Abläufe vorzubereiten, Übergaben zu sichern, Informationen aus verschiedenen Quellen zusammenzuführen und wiederholbare Standards zu schaffen.

Ein Tool beantwortet Fragen. Kompetenz stellt die richtigen.

Der Fokus „ChatGPT-Schulung“ ist deshalb kein Gegensatz zu Copilot, sondern eine Antwort auf dessen Grenzen.

Copilot arbeitet reaktiv innerhalb bestehender Systeme. ChatGPT wird proaktiv gestaltet – durch Prompts, durch Struktur, durch menschliche Entscheidung.

Gerade für Sekretärinnen bedeutet das:

Wer KI versteht, ist nicht ersetzbar. Wer nur klickt, schon.

Chef:innenlogik vs. Assistenzrealität – ein notwendiger Perspektivenwechsel

Zwischen Führungsebene und Assistenz liegt oft kein Konflikt, sondern ein blinder Fleck.

Beide Seiten meinen es gut – schauen aber aus unterschiedlichen Richtungen.

Typische Chef:innenlogik

Copilot automatisiert Prozesse und spart Zeit.

Zusätzliche Schulungen kosten Geld und binden Ressourcen.

Datenschutz ist durch Microsoft geregelt.

Sprache und Stil korrigiert die KI automatisch.

Assistenzrealität

Copilot automatisiert – aber nur innerhalb bestehender Strukturen.

Schulungen schaffen Unabhängigkeit und Handlungssicherheit.

Datenschutz lebt vom Wissen der Anwender:innen.

Sprache bleibt ein Führungsinstrument – auch im Sekretariat.

Sicht der Führung | Sicht der Assistenz |

|---|---|

Tool = Lösung | Kompetenz = Lösung |

Effizienzfokus | Verantwortung & Kontext |

Systemdenken | Prozessdenken |

Automatisierung | Steuerung & Prüfung |

Frau Huber steht genau zwischen diesen Welten. Sie muss Entscheidungen vorbereiten, ohne selbst Entscheiderin zu sein.

Sie trägt Verantwortung, ohne formale Macht zu haben. Genau deshalb braucht sie mehr als ein Tool.

Wer fängt eigentlich die Fehler ab, wenn KI nur Vorschläge macht?

Dieser Perspektivenwechsel ist zentral für den Blog – und für jede Entscheidung über Weiterbildung.

Copilot – der digitale Mitfahrer

Copilot ist leistungsstark. Das steht außer Frage. Er integriert sich nahtlos in Microsoft 365, nutzt vorhandene Daten und beschleunigt Abläufe, die bereits klar strukturiert sind.

Für Frau Huber bedeutet das:

Schnellere Zusammenfassungen. Vorschläge für Antwortmails. Überblick über Meetings.

All das spart Zeit – wenn der Prozess vorher sauber gedacht wurde.

Doch genau hier liegt der Punkt. Copilot fährt nicht selbst.

Er folgt der Route, die Menschen vorgeben. Er entscheidet nicht, ob ein Termin sinnvoll ist. Er erkennt keine politischen Fallstricke. Er bewertet keine Prioritäten zwischen Abteilungen.

Copilot sitzt auf dem Beifahrersitz. Das Lenkrad bleibt beim Menschen.

In der Assistenz endet Copilot dort, wo Arbeit nicht linear ist.

Dort, wo Informationen fehlen. Wo Übergaben unklar sind. Wo Wissen verteilt statt dokumentiert ist.

Frau Huber weiß:

Wenn sie heute nicht selbst strukturiert, fragt Copilot morgen die falschen Fragen – oder gar keine.

Und genau an dieser Stelle öffnet sich der Raum für ChatGPT als strategische Ergänzung.

Copilot sieht, was Mitarbeitende sehen – und genau hier beginnt das Risiko

Copilot arbeitet nicht im luftleeren Raum.

Er sieht genau das, was der eingeloggte Mitarbeitende sehen darf – nicht mehr, aber eben auch nicht weniger. Und das ist in der Praxis brisanter, als vielen bewusst ist.

In vielen Organisationen sind Zugriffsrechte historisch gewachsen.

„Das brauchen wir vielleicht noch“, „Das hatte sie schon immer“, „Das ist praktisch für Vertretungen“ – so entstehen Berechtigungen, die großzügig, aber selten überprüft sind.

Copilot nutzt diese Rechte konsequent.

Praxisbeispiel aus dem Sekretariat:

Frau Huber hat Zugriff auf mehrere SharePoint-Bereiche, alte Projektordner und interne Abstimmungs-E-Mails.

Fragt sie Copilot: „Fasse mir bitte alles Relevante zu Projekt X zusammen“, dann greift Copilot auf alle freigegebenen Inhalte zu – unabhängig davon, ob diese Informationen heute noch gebraucht, sensibel oder eigentlich intern begrenzt sein sollten.

Copilot entscheidet nicht, was er sehen darf. Er folgt den Berechtigungen – auch wenn sie zu weit gehen.

Das Problem ist nicht Copilot. Das Problem ist die Annahme, dass bestehende Zugriffsrechte automatisch „KI-tauglich“ sind. Sie sind es oft nicht.

Gerade im Sekretariat laufen Informationen zusammen: Personal, Termine, Projekte, vertrauliche Abstimmungen. Wenn KI hier mitliest, ohne dass Rollen, Rechte und Verantwortlichkeiten sauber definiert sind, entsteht kein Effizienzgewinn, sondern ein Governance-Risiko.

KI verstärkt, was vorhanden ist – auch schlechte Berechtigungskonzepte.

Deshalb gehört zur professionellen KI-Nutzung zwingend:

regelmäßige Überprüfung von Zugriffsrechten

klare Rollenmodelle

Bewusstsein bei Assistenzkräften, was KI sehen darf – und was nicht

Und genau hier zeigt sich erneut: Ein Tool allein macht keine sichere Organisation. Es braucht Wissen, Sensibilität und Schulung.

ChatGPT – von der Assistenz zur souveränen Fahrerin

Frau Huber hat den Satz „Wir testen Copilot“ inzwischen so oft gehört, dass er klingt wie eine Floskel. In der Chefetage ist es ein Fortschrittszeichen, im Sekretariat ist es erst mal eine Zusatzaufgabe. Denn wenn neue Tools kommen, landet das Feintuning fast immer dort, wo Prozesse zusammenlaufen: bei ihr.

Während Copilot dort glänzt, wo Prozesse bereits definiert sind, beginnt die eigentliche Stärke von ChatGPT genau an der Stelle, an der Arbeit unscharf, vielschichtig und abteilungsübergreifend wird.

Im Sekretariat ist das kein Sonderfall, sondern der Normalzustand. Wer hier täglich zwischen Menschen, Informationen und Erwartungen navigiert, braucht ein Werkzeug, das mitdenken darf, statt nur auszuführen.

ChatGPT wird in der Schulung nicht als Chatbot vermittelt, sondern als strategische Arbeitsumgebung.

Eine Umgebung, in der Assistenzkräfte lernen, ihre Denkprozesse zu strukturieren, Wissen zu bündeln und Aufgaben so vorzubereiten, dass sie tragfähig, überprüfbar und wiederholbar werden. Genau das unterscheidet reines „KI-Nutzen“ von echter KI-Kompetenz.

Eigene Prompts und eigene GPTs – vom Bauchgefühl zur Systematik

Eine souveräne Assistenz arbeitet nicht jeden Tag neu, sondern entwickelt Standards, die tragen.

Mit eigenen Prompts und eigenen GPTs lässt sich dieses Erfahrungswissen erstmals systematisch abbilden – unabhängig von einzelnen Personen, Tagesformen oder spontanen Eingebungen.

Stellen Sie sich vor, Frau Huber erstellt einen GPT speziell für Onboarding-Prozesse.

Dieser kennt Abläufe, typische Fragen, interne Zuständigkeiten und sprachliche Standards – und liefert konsistente Ergebnisse, egal wer gerade vertritt. Das ist keine Spielerei, sondern Qualitätssicherung durch Struktur.

Praxisbeispiel 1:

Für Onboardings neuer Kolleg:innen hat sie ein eigenes GPT erstellt. Es kennt Abläufe, Ansprechpartner, Formulierungen und Fristen – unabhängig davon, ob gerade jemand Zeit hat, alles zu erklären.

Ein eigener GPT für Onboardings sorgt dafür, dass neue Kolleginnen strukturiert, vollständig und einheitlich eingearbeitet werden – auch wenn Frau Huber im Urlaub ist.

Besonders wertvoll wird ChatGPT dort, wo Wissen verteilt ist.

Projects mit eingebundenen Dokumenten helfen Frau Huber, Übergaben vertretungssicher zu organisieren. Keine Zettelwirtschaft, keine stillen Wissensinseln.

Übersicht – ChatGPT-Kompetenzen im Sekretariat:

| Funktion | Nutzen im Alltag |

|---|---|

| Eigene Prompts/GPTs | Standardisierung & Qualitätssicherung |

| Projects | Wissensdatenbanken & Übergaben |

| Tasks im Chat | Strukturierte Aufgaben ohne Tool-Wechsel |

| Agentenmodus | Mehrstufige Aufgaben effizient bearbeiten |

Frau Huber merkt schnell:

Mit Schulung wird ChatGPT kein Chatbot mehr, sondern ein Arbeitsinstrument auf Augenhöhe. Ohne Schulung bleibt es Oberfläche.

Praxisbeispiel 2: Für Vertretungen hat Frau Huber ein eigenes GPT erstellt, das Übergaben strukturiert: Was läuft aktuell? Welche Fristen drohen? Welche Ansprechpartner sind kritisch? Welche Formulierungen sind heikel? Das GPT erzeugt daraus eine saubere Übergabeseite – kurz, klar, verwendbar. Sie muss nicht mehr im Kopf jonglieren, sie kann führen.

| ChatGPT-Funktion | Konkreter Nutzen für Sekretärinnen & Assistenzkräfte |

|---|---|

| Eigene Prompts & eigene GPTs | Einheitliche Standards, konsistente Tonalität und gleichbleibende Qualität – auch bei Vertretung oder hoher Arbeitslast |

| Projects mit Dokumenten & Wissen | Zentrale Wissensbasis, strukturierte Übergaben und geringere Abhängigkeit von Einzelpersonen |

| Tasks direkt im Chat | Aufgaben klar strukturieren, priorisieren und nachverfolgen – ohne Tool-Wechsel |

| Agentenmodus | Mehrstufige Aufgaben wie Recherchen, Briefings oder Eventvorbereitungen effizient erledigen lassen |

So wird aus „KI nutzen“ etwas anderes: KI führen. Und genau das ist der Kern eurer Schulung.

Datenschutz: Warum Wissen wichtiger ist als Software

Mittwoch, 9:03 Uhr. Frau Huber öffnet eine Mail mit dem Satz: „Das ist doch alles bei Microsoft, das wird schon sicher sein.“ Sie spürt sofort, was dahinter steckt: ein Wunsch nach Ruhe. Ein Wunsch nach „Haken dran“. Doch Datenschutz ist kein Haken dran. Datenschutz ist Verhalten – und Assistenz ist die Stelle, an der Verhalten täglich sichtbar wird.

Copilot arbeitet mit den Rechten des Users. Wenn Zugriffsrechte in der Organisation großzügig vergeben sind, kann Copilot inhaltlich aus Bereichen schöpfen, die zwar „irgendwie freigegeben“, aber nie wirklich geprüft wurden. Frau Huber erlebt genau das: alte Projektordner, halbfertige Entwürfe, interne Abstimmungen. Ein Prompt wie „Gib mir alles Relevante zu Projekt X“ kann dann plötzlich Informationen zusammenführen, die früher nie in einem Dokument nebeneinander lagen. Das ist kein „Datenleck“. Es ist ein Governance-Problem – nur eben jetzt mit Turbo.

Bei ChatGPT liegt die Verantwortung anders. Frau Huber entscheidet aktiv, was sie eingibt. Und genau deshalb braucht sie Regeln im Kopf, nicht nur Richtlinien im Intranet. Was darf hinein? Was muss draußen bleiben? Was ist personenbezogen, was sensibel, was nur scheinbar harmlos? Ohne Training wird aus KI schnell eine Abkürzung, die später teuer wird.

KI verstärkt Prozesse. Wenn Berechtigungen schlampig sind, verstärkt KI auch das.

| Annahme | Realität im Assistenzalltag |

|---|---|

| „Der Anbieter regelt Datenschutz“ | Menschen entscheiden im Prompt, welche Informationen verarbeitet werden |

| „Automatisch ist sicher“ | Automatisierung erfordert bewusste Prüfung und Kontrolle |

| „Nur IT ist zuständig“ | Assistenz handelt täglich mit sensiblen Daten und trägt Mitverantwortung |

Die Fachtagung setzt genau hier an: Sie verwandelt Unsicherheit in Urteilskraft. Und Urteilskraft ist der beste Datenschutz – gerade dort, wo Assistenz täglich Entscheidungen trifft, lange bevor ein Regelwerk greift.

Digitale Souveränität: Europas gefährlicher blinder Fleck

Donnerstag, 16:26 Uhr. Frau Huber sitzt im Zug nach Hause, das Notebook auf den Knien, das Handy in der Hand. Eine Schlagzeile huscht vorbei: „Europa bleibt abhängig von US-Cloudanbietern“.

Sie liest weiter, schmunzelt kurz – und wird dann ernst. Denn sie weiß: Wenn „oben“ über Strategien, Verträge und Partnerschaften entschieden wird, landet die Konsequenz unten. Und unten heißt: im Sekretariat. Dort, wo es trotzdem funktionieren muss.

Digitale Souveränität klingt nach Politik, nach Brüssel, nach Sonntagsreden.Für Frau Huber ist es etwas sehr Konkretes: Arbeitsfähigkeit. Was passiert, wenn ein US-Konzern seine Lizenzmodelle ändert – über Nacht? Wenn Funktionen plötzlich kostenpflichtig werden, eingeschränkt oder ganz verschwinden? Wenn ein Cloud-Dienst aufgrund rechtlicher Auseinandersetzungen in Europa nur noch eingeschränkt verfügbar ist?

Diese Szenarien sind keine Science-Fiction. Unternehmen haben in den letzten Jahren erlebt, wie Dienste abgekündigt, Preise vervielfacht oder Nutzungsbedingungen einseitig geändert wurden. Nicht aus Böswilligkeit – sondern weil US-Unternehmen primär US-Interessen folgen. Europa ist Markt, nicht Maßstab.

Praxisbeispiel aus dem Büroalltag:

Frau Huber verwaltet Vorstandsunterlagen, Terminserien, vertrauliche Abstimmungen. Alles liegt in einer US-Cloud. Ein Update verändert Zugriffslogiken. Eine Funktion ist plötzlich nicht mehr enthalten. Eine neue Datenschutzprüfung verzögert den Zugriff.

Der Vorstand fragt nicht: „Warum?“

Er fragt: „Warum läuft das nicht?“

Was passiert, wenn Ihre Organisation morgen ohne ihr gewohntes Tool arbeiten müsste – auch nur für zwei Wochen?

Organisationen, die KI-Kompetenz mit der Einführung eines einzelnen Tools verwechseln, geraten in solchen Momenten unter Druck. Sie reagieren hektisch, improvisieren, verlieren Zeit und Vertrauen.

Frau Huber will in solchen Momenten ruhig bleiben. Nicht, weil sie Technik ablehnt – sondern weil sie unabhängig denken will.

Genau hier setzt ChatGPT-Kompetenz an. Nicht als Ersatz für Copilot, sondern als zweite Säule. Prompts, Wissenslogik, Aufgabenstruktur, Prüfroutinen – das sind Fähigkeiten, die nicht an einen Anbieter gebunden sind. Sie funktionieren heute mit Tool A, morgen mit Tool B, übermorgen mit etwas völlig Neuem.

Copilot kann viel. Aber Copilot bleibt Teil eines Ökosystems. Die ChatGPT-Schulung zielt auf das, was darübersteht: KI-Mündigkeit. Die Fähigkeit, Arbeitslogik zu verstehen, nicht nur Benutzeroberflächen.

| Nur Tool-Einführung | KI-Kompetenz-Aufbau |

|---|---|

| kurzfristiger Effekt | nachhaltige Resilienz |

| Abhängigkeit von Anbietern | Alternativen denken |

| Bedienung | Steuerung |

| Reaktion auf Veränderungen | Gestaltung trotz Veränderungen |

So wird das Sekretariat nicht zum Anhängsel der Digitalisierung.

Es wird zu ihrem Stabilisator. Zu dem Ort, an dem Arbeit weiterläuft –

selbst dann, wenn Systeme wanken.

Sprache entscheidet – warum KI ohne Urteilskraft gefährlich wird

Ein Blick auf die Schlagzeilen: „Europa kämpft um digitale Souveränität“, „US-Dominanz im KI-Markt bleibt hoch“. Sie lässt den Blick über den Text schweifen und wird ernst. Denn sie weiß: Was in Redaktionen und Konferenzen heiß diskutiert wird, landet im Büroalltag auf ihrem Schreibtisch – ohne Vorwarnung, aber mit voller Wucht.

Digitale Souveränität klingt nach Politik, nach Brüssel oder irgendwelchen Kommissionen.

Für die Assistenz ist es etwas Greifbares: Kontrolle über Arbeitsfähigkeit, Daten, Sprache und Prozesse.

Frau Huber erinnert sich an Kolleg:innen, die während einer Lizenzumstellung plötzlich keinen Zugriff mehr auf bestimmte Dienste hatten. Plötzlich mussten sie Umwege gehen: PDFs manuell exportieren, Screenshots verschicken, unzählige Follow-Ups initiieren. Das alles, weil ein US-Dienst seine API geändert hatte – und niemand es bemerkt hatte, bevor es zu spät war.

Dieses Risiko ist real: Viele KI-Dienste, insbesondere von US-Anbietern, sind proprietär, arbeiten in US-Cloud-Infrastrukturen und folgen oft anderen rechtlichen Rahmenbedingungen als europäischen Standards. Diese Abhängigkeit kann im Krisenfall zu echten operativen Problemen führen: eingeschränkte Nutzung, veränderte Lizenzmodelle oder gar Serviceunterbrechungen. Und während im Hintergrund um Nutzungslizenzen und Marktanteile verhandelt wird, sitzt Frau Huber da und fragt sich: Wo ist mein Arbeitsplatz, wenn die Tools plötzlich anders funktionieren?

In Deutschland und Europa wächst deshalb die Bewegung hin zu offenen, transparenten, datenschutzkonformen KI-Modellen. Ein Beispiel ist Mistral AI, ein KI-Unternehmen aus Paris, das Open-Source-Sprachmodelle entwickelt, die speziell auf Transparenz und Kontrolle ausgelegt sind – mit einer Architektur, die nicht automatisch die Kontrolle an einen einzigen Anbieter abgibt. Quelle Techwanderer

Mistral veröffentlicht Modelle wie Mistral 7B unter offenen Lizenzen, die Unternehmen erlauben, die Technologie lokal, angepasst und datenschutzgerecht einzusetzen – ein starker Kontrapunkt zur üblichen „Cloud Blackbox“.

Ein anderes europäisches Projekt, OpenEuroLLM, verfolgt das Ziel, Modelle zu schaffen, die in allen 24 EU-Sprachen funktionieren und offen genutzt werden können – ein direkter Gegenentwurf zu proprietären Sprachmodellen, die Agenden und Interessen verfolgen, die außerhalb europäischer Werte liegen. Wikipedia

Und dann ist da noch der Duden-Mentor, ein KI-gestütztes Sprachwerkzeug, das speziell für die Anforderungen der deutschen Sprache entwickelt wurde: präzise Rechtschreibprüfung, Stil- und Grammatik-Optimierung und kontextsensible Vorschläge nach aktuellen Duden-Regeln – ganz anders als generische KI-Modelle, die Wahrscheinlichkeiten statt Normen folgen. Duden

Das zeigt: Europa hat Alternativen – aber sie müssen bewusst genutzt, verstanden und integriert werden.

Was bleibt, wenn Ihr Tool plötzlich nicht mehr Ihr Tool ist – aber Ihr Arbeitsprozess weiterlaufen muss?

Digitale Souveränität bedeutet nicht, jede Cloud abzusägen. Sie bedeutet: Strategisch denken, nicht nur reagieren.

Die Assistenz, die heute lernt, wie KI funktioniert – wie man Prompts gestaltet, wie man Daten steuert, wie man Sprache prüft und nutzt – hat nicht nur Werkzeuge in der Hand, sondern Urteilskraft. Diese Urteilskraft ist nicht an einen Anbieter gebunden – sie überdauert Tools, Geschäftsmodelle und Marktverschiebungen.

Copilot kann heute Teil der Infrastruktur sein. Aber der Verstand, der entscheidet, wann Copilot schweigen muss und wann KI sprechen darf, gehört der Assistenz.

Aktuelle Rechtschreibung ist kein Nebenbei-Thema – Sprache entscheidet über Wirkung und Verantwortung

Frau Huber liest eine E-Mail, die in ihrem Namen an den Vorstand gehen soll. Der Inhalt ist korrekt, die Fakten stimmen. Und doch hält sie inne. Ein Wort wirkt sperrig, eine Formulierung unsauber. Nichts Dramatisches – und genau das macht es gefährlich. Denn kleine sprachliche Fehler sind leise. Sie fallen nicht sofort auf. Aber sie wirken.

Viele glauben, Rechtschreibung erledige sich heute nebenbei. Die KI korrigiert das schon.

Doch Frau Huber weiß: So funktioniert Sprache nicht.

KI-Tools orientieren sich an statistischen Wahrscheinlichkeiten. Sie berechnen, was häufig vorkommt – nicht, was verbindlich gilt. Normen, wie sie in der amtlichen Rechtschreibung festgelegt sind, spielen dabei nur eine untergeordnete Rolle.

Mit der 29. Auflage des Dudens haben sich Regeln verändert, Präzisierungen wurden vorgenommen, Schreibweisen vereinheitlicht. Diese Änderungen fließen nicht automatisch, vollständig oder korrekt in generische KI-Modelle ein. Wer sich blind auf Vorschläge verlässt, übernimmt oft unbemerkt veraltete oder informelle Schreibweisen – gerade dort, wo es formell sein müsste.

Praxisbeispiel aus dem Sekretariat:

Ein Protokoll wird archiviert. Eine Einladung geht an externe Partner. Eine Vertragsanlage wird vorbereitet.

Ein falsch gesetztes Komma, eine uneinheitliche Schreibweise, eine unsaubere Groß- und Kleinschreibung – all das wirkt nicht nur unprofessionell. Es kann reputationsschädigend sein. In bestimmten Kontexten sogar haftungsrelevant.

KI korrigiert Texte. Aber sie trägt keine Verantwortung für ihre Wirkung.

Professionelle schriftliche Kommunikation erfordert deshalb mehr als Autokorrektur.

Sie erfordert aktuelles Regelwissen, das bewusst vermittelt, eingeübt und reflektiert wird. Frau Huber muss entscheiden können: Übernehme ich diesen Vorschlag? Passe ich ihn an? Oder verwerfe ich ihn bewusst?

Genau hier setzt die Schulung an. Sie stellt sicher, dass Assistenzkräfte neue Rechtschreibregeln nicht nur kennen, sondern anwenden können – auch im Zusammenspiel mit KI. Sie lernen, Vorschläge zu prüfen, nicht zu kopieren. Sie gewinnen Sicherheit im Ausdruck, statt sich auf Technik zu verlassen.

| Ohne Schulung | Mit Schulung |

|---|---|

| Übernahme von KI-Vorschlägen | bewusste sprachliche Entscheidung |

| Unsicherheit bei neuen Regeln | sichere Anwendung aktueller Normen |

| formale Fehler im Detail | professionelle, konsistente Sprache |

| Technik bestimmt den Ton | Mensch steuert Wirkung |

Schlussgedanke: Wer steuert eigentlich Ihr digitales Unternehmen?

Sie haben gesehen: Copilot ist ein leistungsstarkes Werkzeug. Er beschleunigt Abläufe, ordnet Informationen und nimmt Routinen Arbeit ab. Doch er denkt nicht voraus, trifft keine Entscheidungen und trägt keine Verantwortung. Genau dort beginnt die Rolle der Assistenz – und genau dort endet die Illusion, dass Technik allein ausreicht.

Ihre Sekretärinnen und Assistenzen arbeiten nicht in einzelnen Tools, sondern zwischen Menschen, Erwartungen und Prozessen. Sie halten Fäden zusammen, wo Systeme enden. Deshalb brauchen sie mehr als Klickwissen: Sie brauchen KI-Kompetenz, Urteilsfähigkeit und die Sicherheit, Technologie bewusst zu steuern – statt ihr zu folgen.

Dieser Beitrag hat gezeigt, warum digitale Souveränität kein abstraktes Schlagwort ist, sondern tägliche Praxis. Abhängigkeit von einzelnen Anbietern, großzügige Zugriffsrechte, unreflektierte Automatisierung und ungeprüfte Sprachvorschläge sind Risiken, die sich nicht durch Software lösen lassen. Sie lassen sich nur durch Wissen, Training und Haltung beherrschen.

Sie haben gesehen, dass ChatGPT dort ansetzt, wo Copilot endet: beim Aufbau von Struktur, beim Gestalten von Wissen, beim Denken in Prozessen. Eigene Prompts, Projects, Tasks und Agentenmodi sind keine Spielerei – sie sind Werkzeuge für eine Assistenz, die vorausdenkt und Verantwortung übernimmt.

Und Sie haben gesehen, warum Sprache kein Nebenbei-Thema ist. Aktuelle Rechtschreibung, klare Formulierungen und sprachliche Entscheidungssicherheit sind Führungsinstrumente. Wer KI-Vorschläge blind übernimmt, delegiert Wirkung – und damit Autorität. Wer Sprache beherrscht, führt auch im digitalen Raum.

Am Ende geht es um eine einfache, aber entscheidende Frage: Wollen Sie reagieren – oder gestalten? Wollen Sie abhängig sein von Tools – oder handlungsfähig durch Kompetenz? Ihre Assistenz ist bereit, diese Verantwortung zu tragen. Geben Sie ihr nicht nur Werkzeuge. Geben Sie ihr Wissen, Sicherheit und Vertrauen.

Denn Copilot kann begleiten.

Aber gesteuert wird Ihr Unternehmen immer noch von Menschen.

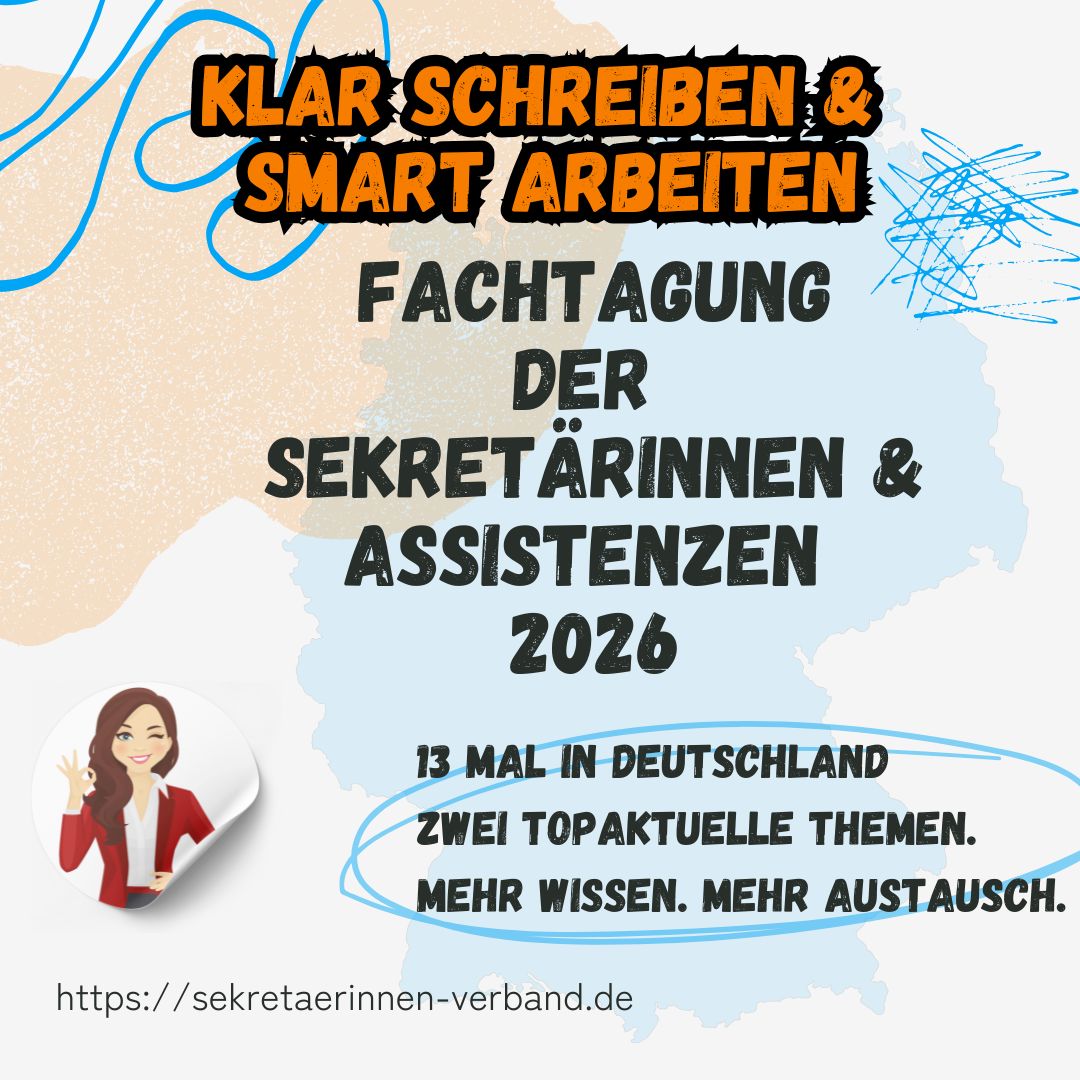

Viele der hier behandelten Inhalte entstehen aus dem Austausch mit Teilnehmenden der Fachtagungsreihe des Verbands der Sekretärinnen. Sie spiegeln Fragen, Erfahrungen und Entwicklungen aus dem Büroalltag wider.

Konkret für diesen Beitrag war es die Rückmeldung eine Stamm-Teilnehmerin, dass die Chefetage eine ChatGPT Schulung nicht für sinnvoll erachtet, weil jetzt die Einführung vom Copilot geprüft wird.